ollama 安装与使用

ollama 官方网址:https://ollama.com/

安装版本: 0.15.4

安装

Linux 安装 URL:https://ollama.com/download/linux

在 Linux 环境下,可以使用网站提供的一件安装脚本:

curl -fsSL https://ollama.com/install.sh | sh

若安装不顺利,则可以通过手动方式安装:

下载文件:

wget https://ollama.com/download/ollama-linux-amd64.tar.zst

安装文件:

sudo tar --use-compress-program=unzstd -xvf ollama-linux-amd64.tar.zst -C /usr/

启动 ollama:

ollama serve

在另一个终端中,验证ollama是否正在运行:

ollama -v

:::color4

注意:

如果 ollama 监听所有网卡的11434 端口,可能存在被利用的情况。可以通过以下 3 种方法减少隐患。

- 方法 1: 启动前设定

OLLAMA_HOST的环境变量,比如OLLAMA_HOST=127.0.0.1。这样,ollama 只会监听本地回环地址(127.0.0.1),外网用户无法访问。 - 方法 2:从防火墙上禁止:

- Linux(iptables):

sudo iptables -A INPUT -p tcp --dport 11434 -j DROP。 - Linux(UFW):

sudo ufw deny 11434。 - Windows 防火墙:

New-NetFirewallRule -DisplayName "Block Ollama External Access" -Direction Inbound -LocalPort 11434 -Protocol TCP -Action Block。

- Linux(iptables):

- 方法 3:在外部防火墙关闭 11434 端口。

:::

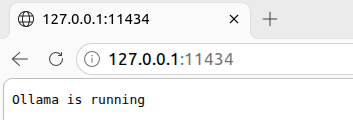

从浏览器中访问 11434 端口,也可看到运行状态:

添加ollama作为启动服务(推荐)

为ollama创建用户和组:

sudo useradd -r -s /bin/false -U -m -d /usr/share/ollama ollama

sudo usermod -a -G ollama $(whoami)

在/etc/systemd/system/ollama.service中创建服务文件:

[Unit]

Description=ollama Service

After=network-online.target

[Service]

ExecStart=/usr/bin/ollama serve

User=ollama

Group=ollama

Restart=always

RestartSec=3

Environment="PATH=$PATH"

[Install]

WantedBy=multi-user.target

启动服务:

sudo systemctl daemon-reload

sudo systemctl enable ollama

配置

更改 models 存放位置

默认配置下,ollama 的模型文件会存放在家目录下,比如 Linux 系统的 models 在 $HOME/.ollama/models目录里。如果需要更改,则可以通过修改OLLAMA_MODELS环境变量来设置位置。

windows

如果是 Windows,要更改 ollama 存储下载模型的位置而不是使用主目录,请在用户帐户中设置环境变量 OLLAMA_MODELS。然后重新启动 ollama 生效。

Linux

在/etc/systemd/system/ollama.service文件中[Service]部分的Environment字段后,添加新的Environment字段,指定新的模型路径:Environment="OLLAMA_MODELS=/data/ollama/models"。然后重新启动 ollama 生效。

更新

通过再次运行上面的安装脚本来更新 ollama 即可。

删除

删除 ollama 服务:

sudo systemctl stop ollama

sudo systemctl disable ollama

sudo rm /etc/systemd/system/ollama.service

从 lib 目录中删除 ollama 库( /usr/local/lib、 /usr/lib或 /lib):

sudo rm -r $(which ollama | tr 'bin' 'lib')

从 bin 目录( /usr/local/bin、 /usr/bin 或 /bin)中删除 ollama 二进制文件:

sudo rm $(which ollama)

删除下载的模型和 ollama 服务用户和组:

sudo userdel ollama

sudo groupdel ollama

sudo rm -r /usr/share/ollama

使用

从ollama -h得知以下使用方法:

$ ollama -h

Large language model runner

Usage:

ollama [flags]

ollama [command]

Available Commands:

serve Start Ollama

create Create a model

show Show information for a model

run Run a model

stop Stop a running model

pull Pull a model from a registry

push Push a model to a registry

signin Sign in to ollama.com

signout Sign out from ollama.com

list List models

ps List running models

cp Copy a model

rm Remove a model

launch Launch an integration with Ollama

help Help about any command

Flags:

-h, --help help for ollama

-v, --version Show version information

Use "ollama [command] --help" for more information about a command.

ollama 安装与使用

https://www.seafog.cn/archives/EnquYVxu